第一章云计算概述

ICT:ICT 是世界电信协会在2001 年的全球会议中提出的一个综合性概念,ICT 分为了IT 和CT 两个领域,其中IT 叫做information technology 信息技术,CT 称为Communication Technology 通信技术。CT 负责的是对数据进行传输管理,比如有线传输、无线传输、基站传输、光传输、网络安

全、卫星通信,CT 技术是ICT 技术栈的底核。IT 称为信息技术,负责的是对数据的全生命周期进行管理。数据的产生一定需要计算资源,计算资源负责生成数据,之后数据会经历存储、数据如果需要多端协同,会经历云平台,对于一些重要的数据,会经历大数据的计算。对于一些核心的数 据,比如你的人脸数据,行为数据等,可以交给AI 进行学习。数据有产生就一定要有交互,这时候就需要IoT

数据中心DC:DC 主要是负责做IT 相关服务的一个底层架构,主要包含了网络、计算、存储、电力、散热、消防等资源在内的一个综合体,将以上的资源整合在一个物理空间内的时候,其就被称为数据中心。数据中心又被称为机房,只是一般来说根据约定俗成,我们将资源比较弱的机房叫机房,资源比较好的机房就叫数据中心。数据中心除了以上的硬件资源,还应该包含有相关的软件资源和数据资产

传统IT 的问题

1. 业务上线速度慢:传统 IT 的业务上线要经历硬件设备建设、操作系统部署、中间件软件安装、程序设计与开发,软件应用上线几个步骤,其中最慢的是硬件设备建设和程序设计与开发两个步骤,一般来说硬件设备建设至少需要 1.5-2 个月的时间,程序设计根据规模会持续几周到几个月不等。这会导致应用的上线速度被大大拉慢。

2. 扩展困难:传统IT 在设计的时候,一般会考虑扩展性,比如带宽、空间……,但是扩展性设计的上限一般都不会特别的高,一般企业IT 架构设计会按照客户需求的1.5 倍-2 倍进行资源设 计。比如客户需要256G 内存,配置的时候一般就会选配到320G+,带宽设计为500Mbps,实际交付就不会低于800Mbps。但是这种设计还是有上限存在的。对于大规模的数据中心的业务扩展实际上是很难能够满足的,因为用户资源扩展的速度要远远超过基础设施扩展的速度

3. 可靠性不高:高性能的数据中心可靠性是非常强的。但是并不是每个客户都能有足够的预算支持高安全性和高可靠性的架构设计的。这时候架构的安全性就成为了一个很重要的问题点,尤其会出现在以下几个方面:

a. 单点故障:如果从源到目标端使用单线联系,一旦出现问题之后,就会造成业务中断,一般情况下,为了解决单点故障,我们会在源端和目标端之间建立多线链接,这时候我们就称该架构具有冗余性。

b. 数据安全性:在DC 中,数据安全是一个非常重要的事情,数据安全体现在两个层面,一个是数据完整性安全,一个是数据传输安全,所谓数据完整性安全指的是存储设备需要对数据做好良好的保护,不能随便的丢失或损坏。解决该问题的方法一般是备份,数据传输安全的可靠性一般体现在被网络攻击,被系统攻击,解决该问题的方法一般是在网络中部署防火墙。

4. 生命周期管理复杂:数据从产生到删除,完整的生命周期中,数据需要经历多重传输和处理,经过若干台设备。在这个传输过程中,如何进行全局化的管理就是一个问题。

5. I/O 瓶颈导致延迟:IO、Input/Output 输入输出,本质上指的就是带宽,有瓶颈会导致排队,排队就会产生延迟。延迟原因有很多,最经典的就是带宽,当然也会有资源不足导致的故障,比如系统的内存不足导致处理过慢。

6. TCO 极高:TCO 企业总拥有成本,一般指的是企业拥有单位算力的成本值,在自建机房中,该成本是非常高的。这就很容易将企业转变为重资产企业。

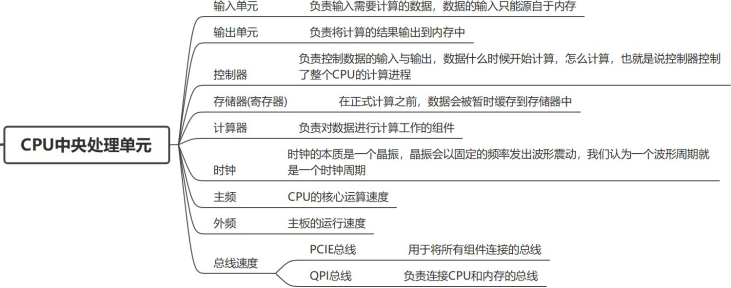

计算:

使用电子设备进行的任何活动都是计算,能够进行高速计算的设备就叫做计算机

并行、串行、集群、分布式、分布式集群的概念

1. 并行:同时运行

2. 串行:按顺序执行

3. 单机:业务的整个生命周期全部都是由一台设备进行相应的

4. 集群:多台物理的设备在逻辑上整合为一个对外的单位提供服务。集群的最大优势在于可以提供负载均衡

5. 分布式:将一个任务拆分为若干个子任务,交给不同的设备去执行,那么设备之间的关系就叫做分布式。使用分布式可以降低IO 瓶颈,提高程序运行效率和相应速度。

6. 分布式集群:将一个任务拆分为若干个子任务,然后将子任务交给不同的一群设备去执行。这群设备在逻辑上是一个个独立的单位。

云计算的核心价值:

1. 按需自助服务:该优势实际上应该叫做云技术的优势,用户可以根据自己的需求按需进行资源定制,这种方式可以极大程度上提升资源的利用率

2. 广泛的网络接入:简单来说,就是有网络的地方,能访问到云的地方就可以使用云计算

3. 资源池化:资源池化可以将整体的资源进行拆分,也可以将分散的资源进行整合。提供了极高的资源灵活性配置。

4. 快速部署,弹性扩容:相较于传统的IT 架构动辄8-12 小时的部署时间,云架构的部署时间就

只需要3-5 分钟,如果使用云原生架构,部署容器,那么只需要1 秒的时间。所以针对于时间性要求比较高的应用,使用云技术可以快速满足客户的需求

5. 可计量服务:云技术可以针对于所有的应用和资源进行计量,例如CPU 核心、内存大小、硬盘的大小、服务使用的次数……,针对于可计量性,那么就可以实现计费。

6. 节约成本,降低TCO:在传统架构中,针对于某一个服务,部署需要物理机,新服务就需要采购新的设备,云架构的天然共享性可以节约企业成本,并且如果用户使用的是云服务,可以为企业节省大量的资金。

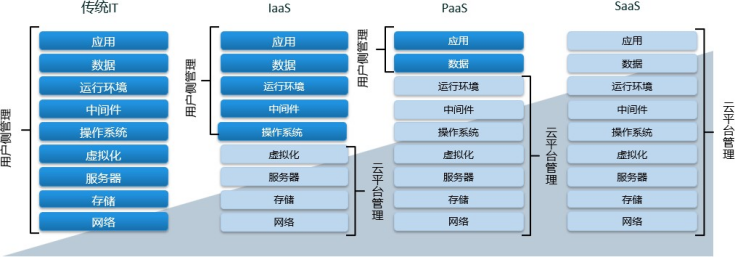

云服务的模式:

中间件:中间件指的是该模块处于操作系统和应用业务之间的技术架构。比如数据库、JVM、PVM……,一般可以理解为是对应用程序的支撑部分,其并不属于应用本身,但是在应用运行的过程中有需要调用的架构,这种软件框架就叫做中间件。

1. 传统IT 架构:在传统模式中,所有的架构都需要用户自己去搭建,出问题需要用户自己修复,

2. IaaS:基础设施即服务,基础设置主要是指资源,分为了CPU、内存、硬盘、网络。然后同时为用户提供了操作系统,用于调用这些资源。操作系统层之上的所用的内容,都由用户自己负责。

a. ECS 弹性云服务器:用最简单的话说就是可以调整配置的虚拟机。

b. BMS 裸金属服务器:云化的物理机,本质上购买一个BMS 就等于拥有了一台物理机的使用权

c. CCE 云容器引擎:主要是负责云容器的创建、删除、使用等相关管理。

3. PaaS:平台即服务,提供的是安装部署好中间件的环境,用户直接部署应用就可以了。可以进一步提升效率、

4. SaaS:软件即服务,如果你作为一个用户,没有任何软件,只有需求,那么就可以使用SaaS 服务,SaaS 服务是搭建好的应用,用户可以直接使用,一般是按次收费的。

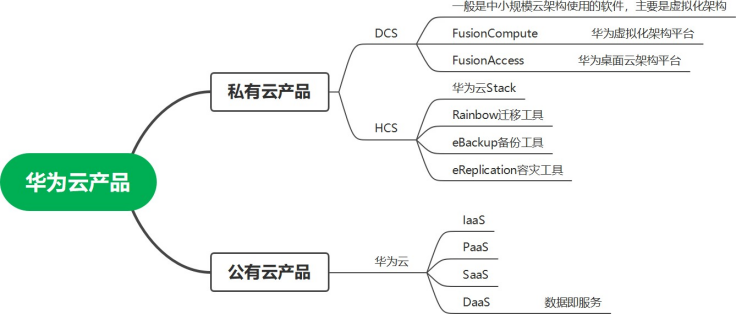

云部署的模式:

1. 公有云:对外面向于公众的云环境,一般是由云厂商负责搭建、维护和服务提供。按资源使用量收费。阿里云、华为云、腾讯云、亚马逊、天翼云、网易云、苏宁云

2. 私有云:内部使用的云环境,完全不对外。福田政务云、宝安机场云

3. 混合云:又有公有云的部分,又有私有云的部分,一般适用于数据部分对外,部分保密的场景。比如粤康码

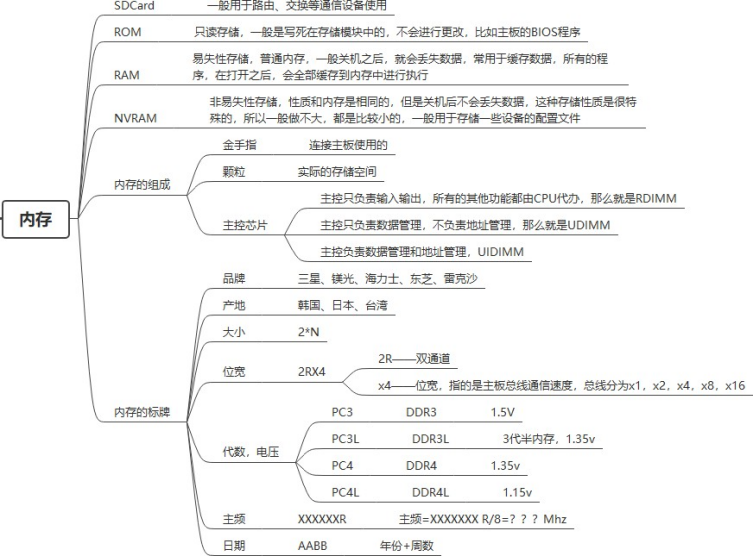

第二章:服务器基础服务器是什么?

服务器本质上就是个性能超强的台式机

1. 可靠性:所有服务器的组件都是有冗余性的

2. 可用性:服务器的性能要远远高于普通的PC

3. 可扩展性:服务器的扩展性能要比传统PC 强

4. 可管理性:服务器在不开机的情况下,仍然可以进行远程管理,服务器中有一个IPMI 芯片,可以允许设备在不开机的情况,用户远程控制

5. 易用性:用户使用服务器和使用PC 是一样的,所以没有学习门槛

设备的标准大小

设备往往都是安装在机柜上的,机柜是一个固定大小和规格的框架,机柜的规格首先根据设备的不同,分为了数通机柜和服务器机柜。数通机柜和服务器机柜的区别在于深度。所有的机柜都会区分高度,高度的单位是U(unit 单元),根据国际标准,机柜的标准高度有48U、42U、36U、32U、24U、16U、8U、4U;1U 是1.75 英寸,也就是4.445 厘米,1U 会被分成3 个高度位。

服务器或者是其他设备,根据产品的不同,分为了1U 设备,2U 设备,4U 设备,8U 设备,

16U 设备

计算机领域中的所有问题,都可以通过添加一个中间层来进行解决

服务器硬件组成

计算机领域中,所有希望同时借鉴两者优势的技术,往往最后都是带有妥协性的

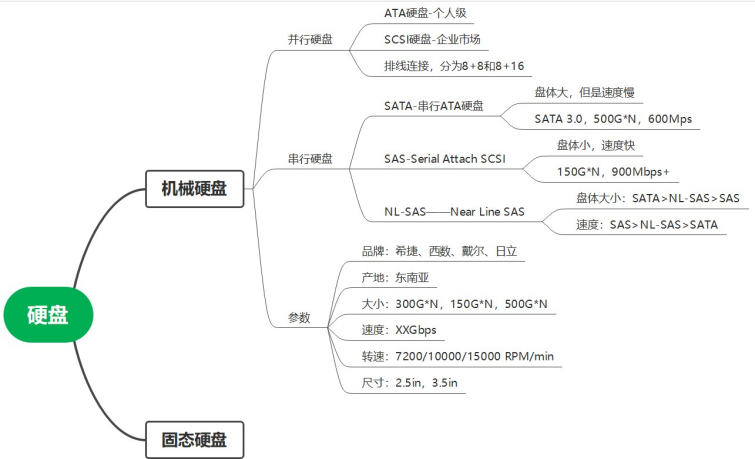

机械硬盘指标:

1. 容量:硬盘的大小

2. 转速:一般来说转速越快,性能越好

3. 平均时间:平均寻道时间,平均等待时间,平均寻道时间指的是磁头切换到目标磁道所需要的时间,平均等待时间指的是磁头到达指定磁道之后,切换到目标扇区的时间。平均寻道时间为4ms,平均等待时间为硬盘旋转一圈时间的一半。假定读取数据的延迟为0。那么一秒钟的时间内,硬盘能够读取多少次呢?

4. IOPS:input output per second 每秒输入输出次数

IOPS=1s/单次读取的时间

=1s/平均访问时间

=1s/(平均寻道时间+平均等待时间)

=1s/(4ms+硬盘旋转半圈的时间)

=1000ms/(4ms+60s/转速/2)

=1000ms/(4ms+30000ms/RPM)

计算题:7200RPM 的硬盘,IOPS 为多少?

存储类型发展:

1. DAS 存储,内部直连存储:内部直连存储指的是存储设备直接通过非网络连接接入到设备中,

存储是通过连接总线主板的方式连接到服务器的。所以虽然存储在服务器物理空间的外部,但是本质上是对服务器内部总线的一个扩展,会有物理范围的限制。所以还是属于内置存储。典型的比如使用SCSI 协议连接的存储。

2. SAN 存储,Storage Area Network 存储区域网络,也就是将存储通过网络进行共享。所有的服务器都可以通过网络连接到存储设备,这就要求存储作为一个独立的个体,需要有自己的管理系统,这个阶段存储就除了单纯的提供空间之外,还需要对空间进行独立的管理、分配。网络一般由IPSAN 和FCSAN 组成

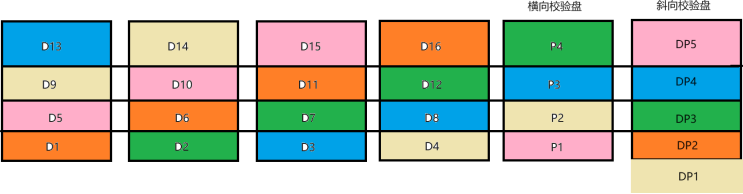

RAID 独立冗余磁盘阵列

1. RAID 是一个阵列,也就是说RAID 至少要有2 块硬盘以上组成

2. RAID 不限硬盘类型,所有硬盘都可以使用。

3. RAID 是一个存储虚拟化技术,可以实现高效安全的数据读写

4. RAID 要求组内的硬盘必须完全相同

RAID 工作流程

1. 硬盘加组之后,首先会按照固定大小进行切分,并且分配编号,这个空间就被称为条带,固定大小由用户设置,最小4MB

2. 将具有相同编号的条带进行组合,形成分条。在这一步,物理的存储空间就会打破物理限制,形成逻辑空间

3. 将硬盘中所有的空间都按照1/2 步的形式组成一个完整的空间,这个空间的大小就等于物理硬盘的合

4. 概念:

a. 条带:物理硬盘切分的空间就被称为条带

b. 分条:具有相同编号的条带组成的逻辑空间就叫做分条

c. 分条宽度:分条空间跨越了多少物理硬盘

d. 分条深度:分条的大小=条带的大小*分条宽度

5. RAID 的状态

a. 创建:用户创建RAID,完成RAID 配置

b. 工作:RAID 正常工作

c. 降级:RAID 出现故障,但是还没有造成数据丢失的时候

d. 失效:RAID 故障导致已经无法恢复,数据丢失

e. 重建:RAID 降级的时候,进行数据恢复,并恢复到工作的过程中

6. RAID 级别(RAID 0,1,3,5,6,10,50):

a. RAID 0:无差错控制的条带化阵列

RAID 0 出现的时间,在硬盘出现的早期,那个时候硬盘的空间大小是比较小的。所以RAID 0

主要是为了两个目的,第一个是将小空间合并为大空间,第二个是提升硬盘的读写速度。

RAID 0 将所有的空间都做为数据盘提供服务,不带有任何的差错控制机制。读数据的时候,就所有盘工作,写数据同理。有多少盘,就多少盘并发。

RAID 0 允许使用所有硬盘作为数据盘,所以RAID 0 的效率非常的高,但是RAID 0 是没有差错控制机制的,只要RAID 0 中损坏一块盘,所有数据就全丢。

所以一般来说我们称RAID 0 提供了极致的速度。

b. RAID 1:镜像结构的条带化阵列

RAID 0 提供了极致的速度,但是安全性完全没有,所以RAID 1 填充了安全性空白,RAID 1采用的结构叫做镜像阵列,说白了就是复制。RAID 组内有多少硬盘,就复制多少份,所以RAID 1非常安全,可以允许损坏到只剩下一块硬盘。

RAID 1 的硬盘所有空间都用于存储数据,不带有任何效率提升,所以读写RAID 1 和读写单盘没有任何区别。所以RAID 1 一般来说不会有很多的硬盘组成,因为太浪费空间。

c. RAID 3:奇偶校验的条带化阵列

RAID 0 提供了极致的速度,RAID 1 提供了极致的安全,RAID 3 在一定程度上对两者的优势

做了结合。RAID 3 第一次提出了数据盘和校验盘的概念。使用奇偶校验保证数据。奇偶校验以相同为假,相异为真作为原则,用户的数据只会写入到数据盘,然后根据数据盘中的数据计算校验码。存入校验盘中。

奇偶校验的最大的优势,就是无序性。我们计算不需要考虑任何顺序。奇偶校验可以允许不做反算。当有数据丢失的时候,我们直接做奇偶运算得到丢失的数据即可。

在RAID 3 中,第一次出现了降级的概念,当数据盘损坏的时候,我们是无法直接读取该数据盘的数据的。但是我们可以通过奇偶运算得到目标损坏盘的数据的。

在RAID 3 中,第一次出现了重建的概念,数据盘损坏之后,我们更换了新盘之后,系统就会将故障盘中的数据全部重算,写入到新盘,这个恢复的过程就是重建。

RAID 3 最多可以允许损坏1 块硬盘,因为坏的硬盘多了之后,奇偶校验的结果就是损坏的硬

盘奇偶校验的结果,我们无法判断数据的归属。

RAID 3 因为不论修改什么数据,都会带着校验盘一起修改,所以校验盘的热点压力就会特别的高,也就导致硬盘损坏速度很快。

d. RAID 5:螺旋分布式奇偶校验

RAID 3 有热点校验盘,能否解决热点?不能解决热点,能不能分摊压力?可以,所以有了

RAID 5。

在RAID 5 中,是没有热点盘的,每个硬盘又做数据又做校验,我们将校验盘打散为校验空间,均匀的散布在每一块硬盘上。

本质上来说,RAID 5 和RAID 3 没有任何区别,只有校验数据存放的位置发生了变化。

网络基础

网络通信的基本模式

1. 单工模式:广播就是一种典型的单工模式,也就是信息的传递是单向的。

2. 半双工模式:同一个时刻,只能有一个人发消息。

3. 全双工模式:同时多向发送消息。

单位转换

Mbps——M bit per second——Mb/s——1/8 MB/s

猫——model——调制解调器

模拟信号——数字信号,光信号——数字信号

双绞线线序:

直通线、交叉线、反转线

568A、568B、反转线

直通线:终端连接网络设备交叉线:网络设备互联

反转线:管理网络设备的网络管理口连接

随着时间的发展,目前所有网络设备全部兼容交叉线,568B 标准。

568B:白橙、橙、白绿、蓝、白蓝、绿、白棕、棕

IP 基础

IP 是一个网络中的唯一标识的逻辑地址,我们在网络中通信的时候,IP 地址不能冲突。但是跨网络的时候,IP 地址是可以重复的。也就是说,在一个网络的内部,IP 地址不能有重复。

IP 地址用于标识网络中的唯一的一台设备,同时IP 地址可以用于通信。

我们认为IP 地址等同于人的名字,可以允许有重复,但是不能在组织内部重复,如果将所有的设备都进行标识的时候,就不能使用IP。这个时候就需要靠MAC 地址,也就等同于身份证号。

IP 地址为32 位的点分十进制数,我们将32 位按照每8 位一个单位,用.划分,然后再将每个8 位转换为十进制,所以叫点分十进制数。

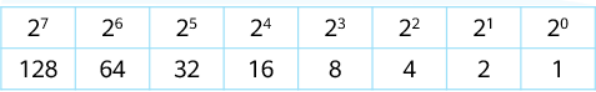

二进制:

171=10101011

214=11010110

191=10111111

127=01111111

10=00001010

172=10101100

192=11000000

224=11100000

IP 地址范围:0.0.0.0——255.255.255.255 11010110=214

十六进制:0-E

十进制——二进制——十六进制

218=11011010=DA

IP 地址根据实际的需求分为了A——E 5 个类别:

A 类:一般用于北美/拉美地区的IP 分配,欧洲有一部分

B 类:一般用于亚洲/欧洲分配使用

C 类:大部分分配给了非洲地区

D 类:一般用于组播地址以及大洲分配

E 类:保留地址,分配给全球科研机构使用

分配IP 地址的单位叫做AINA,所有的IP 地址必须要和该组织购买才能使用。

IP 地址一共有4297483647 个,现在已经完全分配完了,没有可用地址了。所以为了节约IP,在网络内部不上网的时候,实际上是没有必要分配公网IP 的。

所以我们指定了几个地址端,用于内部网络互通使用。分别为:

10.0.0.0-10.255.255.255

172.16.0.0-172.31.255.255

192.168.0.0-192.168.255.255

用户配置这三段地址中的IP 的时候,是不能直接上网的。特殊IP:

0.0.0.0代表全球所有的IP

255.255.255.255全局广播地址

127.0.0.1本地回环接口地址

169.254.0.0/16微软专用

IP 地址分为了网络位和主机位,网络位可以理解为组编号,具有相同的网络位的IP,在同一个组内。主机位就是ID,也就是组内的编号。

子网掩码用于标识网络位和主机位。子网掩码的1 代表网络位,0 代表主机位。1 和0 必须连续,不能穿插。

每组的主机位的第一个IP 代表当前全组,不能配置,每组IP 的最后一个地址,代表组内广播,当有消息发送到最后的地址时,组内所有的主机都能收到。

所以主机组部分可用IP 为2^主机位-2

子网掩码的位数是可调整的。不是固定必须要以8 位为一个单位。

比如,用户需要一组内有300 个IP 可使用。要求分配192.168.11.0 网段,请问子网掩码应该是多少?

/23

请问172.16.12.122/27,这个地址的网段号和广播号是多少?

172.16 .12 .01111010

255.255.255.11100000

172.16.12.01100000

172.16.12.96——127

192.168.11.0/26

192.168.11.0——63(1-62)

192.168.11.64——127(65-126)

192.168.11.128——191(129-190)

192.168.11.192——255(193-254)

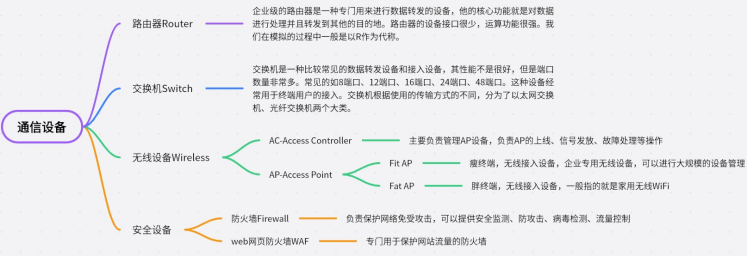

网络的基本架构

现代网络架构一般遵循的是三层网络架构,分别为接入层、汇聚层、核心层

接入层:接入层是负责将各种类型的设备接入到网络中的一个层级,一般是交换机或者是无线AP组成的。接入层往往会面向大量的用户,所以接入层的设备端口会非常多,同时因为每台设备所转发的流量并不是很大,所以一般来说接入层设备会以多端口,低性能为主。

汇聚层:汇聚层负责将接入层接入的设备流量汇聚到本层中。

核心层:核心层负责将整个网络的所有流量汇聚到自身,然后进行统一的流量转发。

新型网络架构:园区网络架构

在大型数据中心和园区网中,三层架构进行数据转发的延迟一般会比较高。所以一般来说会选择大

二层网络。大二层网络的核心思想就是为了减少层级,降低延迟。所以大二层网络只有leaf 和

spine 节点。leaf 就是叶节点,可以等同于接入层。spine 就是主干节点,负责流量转发。三层架构一般用于普通网络架构,大二层网络目前在大型数据中心中应用最为广泛。

网络分类:

1. 局域网:按照网络影响的大小进行划分,在一个组织内部的网络就被称为局域网

2. 城域网:以城市为范围的网络,比如教育网、电力网、石油网

3. 广域网:理论上全球互联网的合集就叫做广域网。广域网也可以等同于英特网(internet)

以太网:

不论什么网络,其所使用的技术,都叫做ethernet,翻译为以太网,以太网就是现代互联网的基础。

根据速度的不同,以太网分为以下的类型Ethernet——E——10Mbps 以太网FastEthernet——FE——100Mbps 以太网GibitEthernet——GE——1000Mbps 以太网

TibitEthernet(10G Ethernet)——TE、10GE——10000Mbps 以太网

交换机

二层交换机和三层交换机,所谓二层交换机,就是指交换机只能识别到数据链路层的报文,也就是说该类型的交换机只能识别mac 地址。三层交换机指的就是交换机带有路由器的功能,可以识别网络层的报文,也就是说该类型的交换机可以识别IP,进行报文转发和路由寻址。目前我们使用的交换机以三层交换为主。三层交换机在不做任何配置的情况下,功能等于二层交换。

TCP/IP 协议栈

应用层:telnet 远程登录管理、FTP 文件传输协议、TFTP 快速文件传输协议、SNMP 网络设备管理协议、HTTP 网络访问协议、

传输层:TCP,可靠传输协议,理解为打电话,必须要建立双向连接才能够进行通信。UDP,非可靠传输协议,理解为发短信,不需要建立连接,直接传输数据,能否收到不控制

网络层:IP,负责以太网传输的核心协议

协议栈,定义了协议的传输标准

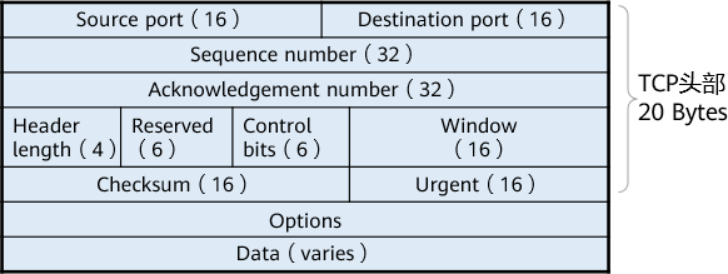

1. Source Port:源端口,发出信息的端口

2. Destination Port:目标端口

3. Sequence Number:序列号,用于包排序使用的

4. Ack Number:确认编号

5. header length:头部长度,一般是固定的20B

6. Control 控制码:

a. SYN:请求建立网络连接

b. FIN:终止连接

c. ACK:确认信息

d. RST:强制中断

e. ……

f. ……

7. Window:窗口大小

VLAN:Virtual Local Area network 虚拟本地局域网

由于现实网络中,经常会出现广播域过大的情况,导致用户收到很多无用的报文,浪费系统开销。为了能够降低广播域,做好管理。我们在物理网络中创建VLAN,进行逻辑隔离。属于不同VLAN的流量不会跨VLAN 发送广播。等于逻辑隔离了广播域。

VLAN 的设计一般是按功能或部门进行划分的。

VLAN 的划分,是通过在报文中插入一个tag 来实现的,具有相同的tag,才能属于一个VLAN,可以互相通信。VLAN 的范围是1-4094。

Access 接口:接入接口,一般是用于连接终端的时候配置。它的特点就是当其收到终端的报文的时候,就打上tag。发送给终端的时候,就拆掉tag。

port link-type access

port default vlan [vlan-ID]

Trunk 接口:干道接口,可以允许多个vlan 通过的接口。

pvid:如果接口收到了一个不带vlan tag 的报文,那么就会按照pvid 设置的vlan,打上一个默认的tag

trunk 接口在转发流量的时候,不会对tag 做任何操作,直接带tag 转发。

port link-type trunk

port trunk allow-pass vlan [vlan id]

虚拟化技术

不论做什么虚拟化,虚拟化都不能脱离物理资源虚拟化是将一种形式的资源抽象成另一种形式

虚拟化的核心作用在于管理底层的物理资源、抽象物理资源形成资源池、将抽象后的资源分配给上层虚拟机系统,并且欺骗系统,让系统认为自己读取的是物理资源

概念:

1. Host Machine:物理机,一般是服务器

2. Host OS:宿主机,运行在物理服务器上的操作系统

3. HyperVisor:虚拟化层,虚拟化技术实现的层级

4. VM:虚拟机,虚拟机实际上是虚拟化层中的资源的抽象集合

5. Guest OS:虚拟机操作系统

虚拟化的类型:

1. 全虚拟化:虚拟化管理器将所有的资源全部虚拟化,也就是虚拟机所看到的资源,是经过了完全虚拟化的,虚拟机无法感知自己使用的究竟是物理资源还是逻辑资源。这种方式的好处就是虚拟机和硬件的适配性会非常强。但是因为涉及到底层和上层的资源虚拟化转换,会有很高的CPU 开销。

2. 半虚拟化:虚拟化管理器只针对计算资源做虚拟化,网络资源和存储资源直接使用底层物理资源,优势在于节省CPU 计算开销。但是对性能有干扰。

3. 硬件辅助虚拟化:即使用相关的辅助硬件来帮助CPU 实现虚拟化,解决CPU 的高消耗。优势在于同时保证了性能和低开销。

虚拟化的特点:

1. 分区:用户可以通过虚拟化管理器将物理资源进行切割,分配给不同的虚拟机,虚拟机之间是完全隔离的,而且不会出现冲突。

2. 隔离:分区的虚拟机为了保证不会互相冲突和干扰,需要做完全隔离,同一个物理机内部的不同虚拟机是无法发现对方的。

3. 封装:物理资源或者是物理机,在看待虚拟机的时候,会将其识别为是一个运行在自身的程序进程。正因为从层级关系来看,虚拟机相当于一个程序进程,所以我们可以针对该进程进行打包。我们可以将该虚拟机所使用的所有的文件和数据全部打包成一个文件。

4. 硬件独立性:在虚拟机封装之后,只要其他系统能够给出同类的资源,那么封装的虚拟机文 件,在解封装之后,就可以运行在其他的设备上。所以虚拟机并不依赖硬件,或者说虚拟机和硬件之间是松耦合的。只要有足够虚拟机运行的资源,那么理论上虚拟机可以在任何位置运 行。

Xen 裸金属虚拟化:

裸金属虚拟化框架中,取消了关于宿主机的部署。对于裸金属框架来说,我们要安装的时候,主要装配的就是Xen 框架,即基于Xen 的VMM。取消了宿主机。

正常情况下,电脑开机,加载BIOS 硬件自检(CPU、内存、主板),读取硬件配置(主要是硬盘),加载系统引导,进入系统。

在裸金属虚拟化中,实际操作中流程为:电脑开机——硬件自检——加载Bios——读取硬件配置—

—加载Xen 程序——进入虚拟化管理器。

KVM 宿主机虚拟化:

宿主机虚拟化的本质在于其在物理资源和VMM 之间搭建了hostOS,这种方式使用资源的优势在于其具有灵活性,使用场景更加广泛,而且其并不是单一用途。

在XEN 中,VM 访问硬件使用的是虚拟驱动,实际访问的是经过XEN 虚拟化后的逻辑资源。

在KVM 中,VM 访问硬件使用的是QEMU,QEMU 包装了虚拟化资源,资源的来源实际上是

HostOS。

所以KVM 的虚拟化本质上比XEN 要多一层,这就意味着更多的资源消耗和更高的资源延迟。

DCS——FusionSphere——FusionCompute

——FusionAccess Fusion——FusionSphere 云DCS 产品

FusionInsight 大数据产品——MRS 服务

FusionMinier AI 产品——ModelArts 服务

FusionSphere 套件

1. FusionCompute:虚拟化框架

2. FusionCompute Pro:高级虚拟化框架

3. eBackup:备份软件

4. UltraVR:容灾软件

5. FusionStorage:分布式存储

部署模式:

1. 小规模部署:VRM 以虚拟机的形式安装在集群中的任意一台服务器中。

2. 大规模部署:VRM 单独部署在一个物理机上

3. 扩展部署:服务器安装CNA,直接加入已有的VRM 集群即可